Der AI Act ist eine Regulierung, die von der Europäischen Kommission vorgeschlagen wurde, um den Einsatz von Künstlicher Intelligenz (KI) in der EU zu regeln. Ziel ist es, ein Gleichgewicht zwischen Innovation und dem Schutz der Grundrechte zu schaffen. Angesichts der zunehmenden Nutzung von KI in Bereichen wie Gesundheit, Verkehr und Sicherheit ist es notwendig, angemessene Richtlinien und Standards zu schaffen, um potenzielle Risiken zu minimieren. Diese Regulierung betrifft nicht nur Entwickler und Unternehmen, sondern auch die Gesellschaft insgesamt, die Vertrauen in die Nutzung von KI-Technologien entwickeln muss (Europäische Kommission).

Ziele und Struktur des AI Acts

In den letzten Jahren gab es zahlreiche Diskussionen über die Auswirkungen von KI auf die Gesellschaft, insbesondere hinsichtlich Datenschutzes, ethischen Fragen und der möglichen Diskriminierung von Einzelpersonen. Die EU hat erkannt, dass bestehende Rechtsvorschriften unzureichend sind, um die Risiken, die mit KI-Systemen verbunden sind, effektiv zu adressieren. Die Hauptziele des AI Act sind der Schutz der Grundrechte und Werte der EU, die Förderung von Innovationen in der KI-Entwicklung sowie die Gewährleistung von Transparenz und Sicherheit in KI-Systemen. Der AI Act soll den Umgang mit den Risiken, die speziell durch KI-Anwendungen entstehen, regeln. Zudem kategorisiert er die Risikoanwendungen durch KI und stellt klare Anforderungen an die KI-Systeme und die Betreiber dessen.

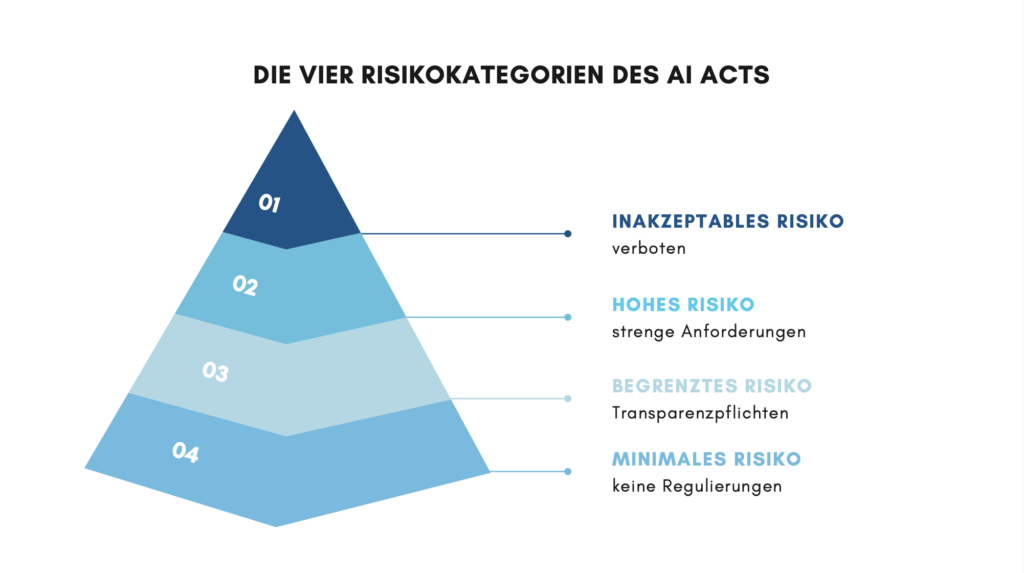

Ein zentraler Bestandteil des AI Act ist der risikobasierte Ansatz, der KI-Systeme in vier Risikokategorien unterteilt: inakzeptables Risiko, hohes Risiko, begrenztes Risiko und minimales Risiko.

KI-Systeme mit inakzeptablem Risiko sind Technologien, die ein zu hohes Schadenspotenzial bergen und daher komplett verboten sind. Diese Systeme unterliegen strengen Anforderungen, die sicherstellen sollen, dass sie verantwortungsvoll eingesetzt werden. Diese Systeme könnten den freien Willen des Menschen manipulieren oder zu gravierenden gesellschaftlichen Ungerechtigkeiten führen. Beispiele für solche verbotenen Praktiken sind:

- Manipulation des menschlichen Verhaltens, um Entscheidungen zu beeinflussen, die den freien Willen umgehen,

- Ausnutzung menschlicher Schwächen, etwa aufgrund von Alter, Behinderung oder wirtschaftlicher Lage,

- Social Scoring nach dem Vorbild sozialer Bewertungen, das zu Diskriminierung führen kann,

- Predictive Policing, also KI-Systeme, die auf Profiling basieren und voraussagen, ob eine Person eine Straftat begehen könnte,

- Ungezielte Gesichtserkennung, bei der Bilder aus dem Internet oder von Überwachungskameras ohne rechtliche Grundlage für Datenbanken verwendet werden und verboten ist,

- die biometrische Echtzeit-Erkennung in öffentlichen Räumen ist nur in sehr wenigen, streng definierten Fällen erlaubt, wie zur Strafverfolgung – und selbst dann nur mit gerichtlicher Genehmigung.

Hochriskante KI-Systeme kommen in kritischen Bereichen zum Einsatz, die das Leben und die Gesundheit der Bürger betreffen, wie beispielsweise in der Verkehrsinfrastruktur, der Bildung, der Strafverfolgung und im Gesundheitswesen. Diese Systeme unterliegen strengen Anforderungen, die sicherstellen sollen, dass sie verantwortungsvoll eingesetzt werden. Dazu gehören unter anderem

- Risikobewertungs- und Risikominderungssysteme: Diese Systeme müssen regelmäßig überprüft und evaluiert werden, um sicherzustellen, dass potenzielle Risiken minimiert werden;

- Hochwertige Datensätze: KI-Systeme müssen mit qualitativ hochwertigen und repräsentativen Daten trainiert werden, um Diskriminierung und Verzerrungen zu minimieren;

- Transparenz und Dokumentation: Es ist erforderlich, umfassende Dokumentationen zu führen, die den Behörden bei der Kontrolle des Systems zur Verfügung gestellt werden.

Begrenzte Risiken sind mit mangelnder Transparenz bei der Nutzung von KI-Systemen verbunden. Um das Vertrauen der Nutzer zu stärken, verlangt der AI Act spezifische Transparenzpflichten. Nutzer müssen darüber informiert werden, wenn sie mit einem KI-System interagieren. Beispiele hierfür sind:

- Chatbots, bei denen Nutzer klar erkennen müssen, dass sie mit einer Maschine und nicht mit einem Menschen kommunizieren.

- KI-generierte Inhalte wie Texte, Audios oder Videos, die als solche kenntlich gemacht werden müssen, damit die Öffentlichkeit die künstliche Herkunft der Informationen erkennt.

Diese Transparenzanforderungen sollen sicherstellen, dass die Interaktion mit KI-Systemen für den Nutzer klar und nachvollziehbar ist.

KI-Systeme mit minimalem oder keinem Risiko umfassen Anwendungen, die keine nennenswerten Gefahren bergen. Diese Systeme sind von strengen Anforderungen befreit und unterliegen keinen spezifischen Regulierungen. Beispiele hierfür sind etwa Videospiele, die KI nutzen, um Spielerlebnisse zu verbessen oder Spamfilter, die dazu dienen, unerwünschte Mails herauszufiltern. Die Mehrheit der heute eingesetzten KI-Systeme fällt in diese Kategorie, wodurch der Fokus der Regulierung auf den risikoreichen Anwendungen liegt und Innovationen im Niedrigrisikobereich gefördert werden.

Diese vierstufige Klassifizierung ermöglicht es, den verschiedenen Risiken angemessen Rechnung zu tragen und gleichzeitig die Innovation und den verantwortungsvollen Einsatz von KI zu fördern (Europäische Kommission, RTR).

Umsetzungsschritte des AI Act

Mit dem Inkrafttreten des AI Act am 2. August 2024 laufen Fristen für die Umsetzung durch Staaten, Unternehmen und Organisationen. Innerhalb von zwölf Monaten muss die nationale Aufsichtsbehörde benannt werden, um die Vorschriften zu überwachen. Österreich hat bereits eine KI-Servicestelle eingerichtet, die Organisationen bei der Vorbereitung unterstützen wird. Ein risikobasierter Ansatz wird verfolgt, wobei KI-Systeme mit höherem Risiko strengen Verpflichtungen unterliegen. Innerhalb der ersten sechs Monate nach Inkrafttreten werden Systeme mit unannehmbaren Risiken verboten. Unternehmen müssen sicherstellen, dass Mitarbeiter, die mit KI-Systemen arbeiten, über die notwendige KI-Kompetenz verfügen.

Auswirkungen auf Unternehmen und Entwickler

Der AI Act bringt umfassende Anforderungen für Unternehmen mit sich. Insbesondere kleine und mittlere Unternehmen (KMU) müssen die Kosten und den Aufwand für die Einhaltung der Vorschriften berücksichtigen (Digital Austria).

Für Unternehmen bedeutet der AI Act erhebliche Anpassungen, die bis Ende 2025 umgesetzt sein müssen (Digital Austria). Dazu zählen:

- Schulung der Mitarbeiter in KI-Kompetenz, unabhängig von der Unternehmensgröße.

- Sicherstellung, dass keine verbotenen Anwendungen (z.B. Social Scoring) angeboten oder genutzt werden.

- Transparenzanforderungen, die erfordern, dass alle KI-Systeme, mit denen Menschen interagieren, sowie KI-generierte Inhalte gekennzeichnet werden müssen. Anbieter sind auch verpflichtet, Informationen über die Trainingsdaten und technische Dokumentation bereitzustellen.

Vom AI Act ausgenommen sind militärische, verteidigungspolitische sowie ausschließlich für Forschung und Innovation genutzte Systeme.

Herausforderungen und Kritik

Kritiker befürchten, dass die Länder der Europäischen Union durch die Regulierungen des AI Acts mit anderen Ländern wie die USA und China im Wettbewerb nicht mithalten können. Die meisten KI-Unternehmen seien kleine Start-Ups und Scale-Ups ohne Rechtsabteilung und die strengen Vorschriften könnten die kleinen Unternehmen belasten und in ihrem Fortschritt einschränken.

Cloud-Modelle vs. On-Premise KI: Welche Rolle spielt der Hosting-Standort im AI Act?

Bisher differenziert der AI Act nicht zwischen cloudbasierten und selbstgehosteten (on-premise) KI-Modellen in Bezug auf ihre Vorgaben, da der Schwerpunkt des Gesetzes auf dem Risikolevel und der Nutzung des KI-Systems, und nicht auf dessen Hosting-Umgebung liegt.

On-Premise KI-Modelle bieten im Gegensatz zu Cloud-Modellen mehrere Vorteile, die es Unternehmen erleichtern können, die Anforderungen des AI Acts einzuhalten. Einer der wichtigsten Aspekte ist die Kontrolle über Daten. Bei On-Premise-Lösungen haben Unternehmen die vollständige Kontrolle über ihre Dateninfrastruktur, was entscheidend ist, um den Datenschutzanforderungen zu entsprechen. Diese Kontrolle ermöglicht es Unternehmen, eigene Sicherheitsprotokolle zu implementieren, die spezifisch auf ihre Bedürfnisse und die Anforderungen des AI Acts zugeschnitten sind (Redapt, Brimit).

Ein weiterer bedeutender Vorteil von On-Premise-Lösungen ist die einfachere Einhaltung der Vorschriften zur Datenübermittlung. Der AI Act sowie die Datenschutz-Grundverordnung (DSGVO) erfordern strenge Maßnahmen bei der Übertragung personenbezogener Daten in Drittländer. Mit On-Premise-Systemen bleibt die Datenverarbeitung, sofern die Rechenzentren in der EU stehen, innerhalb der EU. Dadurch minimieren Unternehmen die rechtlichen Risiken, die mit Datenübertragungen verbunden sind (Redapt). Es ist jedoch entscheidend, dass Unternehmen die geforderten Sicherheitsstandards tatsächlich umsetzen, da sie bei On-Premise-Lösungen für die Datensicherung eigenverantwortlich sind. Können sie dies nicht gewährleisten, wären generell die Cloud-Variante oder der servierte KI-Server von Localmind AI in der Tat eine sichere Alternative, da hier ein hohes Maß an Sicherheit und kontrollierten Zugriff durch dedizierte Server gegeben ist.

Insgesamt lässt sich festhalten, dass keine der beiden Varianten per se überlegen ist, wenn es darum geht, die Richtlinien des AI Acts einzuhalten. Entscheidend ist, dass Unternehmen die Bereitschaft und die Fähigkeit haben, die Richtlinien einzuhalten, vor allem bei KI-System mit höherem Risiko und dementsprechend mehreren Anforderungen.

Fazit und Ausblick

Der AI Act stellt einen entscheidenden Schritt in der Regulierung von KI-Systemen in Europa dar und setzt einen globalen Standard für die Entwicklung und Nutzung von Künstlicher Intelligenz. Die Herausforderungen sind vielfältig, und vor allem Unternehmen müssen sich auf die neuen Anforderungen einstellen.

Schaue hier (Achtung: externer Link) nach, welche KI-Richtlinien euer Unternehmen einhalten muss.