Wenn du schon mal von ChatGPT oder anderen großen Sprachmodellen gehört hast, dann bist du bereits einem Transformer-Modell begegnet. Doch was genau steckt hinter dem Begriff „Transformer“?

Die Grundlagen: Was ist ein Transformer?

Ein Transformer ist eine spezielle Art von neuronalen Netzwerk und maschinellem Lernmodell, das ursprünglich für Aufgaben in der natürlichen Sprachverarbeitung (NLP) entwickelt wurde. Diese Modelle haben in den letzten Jahren enorme Fortschritte gemacht und sind die Grundlage vieler moderner KI-Anwendungen. Die Initialen „GPT“ in ChatGPT stehen für „Generative Pretrained Transformer“. Schauen wir uns das genauer an:

- Generative: Diese Modelle erzeugen neuen Text basierend auf Wahrscheinlichkeiten.

- Pretrained: Sie durchlaufen einen umfangreichen Lernprozess mit riesigen Datenmengen. Das bedeutet, dass sie bereits vortrainiert sind, aber es gibt Spielraum, sie weiter anzupassen.

- Transformer: Hier liegt das Herzstück des Modells. Ein Transformer ist eine spezielle Architektur eines neuronalen Netzwerks, das durch Selbstaufmerksamkeit (Self-Attention) und die Fähigkeit, große Datenmengen parallel zu verarbeiten, besonders gut darin ist, Muster in Daten zu erkennen und zu nutzen.

Wie funktionieren Transformer-Modelle?

Transformer-Modelle arbeiten nach einem mächtigen Prinzip: Sie sagen vorher, was als Nächstes kommt. Stell dir vor, du liest einen Text. Ein Transformer-Modell liest diesen Text ebenfalls und trifft dann Vorhersagen darüber, welches Wort oder welcher Satz als Nächstes folgt. Diese Vorhersagen sind keine festen Entscheidungen, sondern Wahrscheinlichkeitsverteilungen. Das bedeutet, das Modell berechnet die Wahrscheinlichkeit für viele verschiedene mögliche Fortsetzungen.

Ein wesentlicher Bestandteil der Transformer-Architektur ist die Fähigkeit, die Reihenfolge der Wörter zu berücksichtigen. Dies wird durch Positionskodierungen (Positional Encodings) erreicht, die den Tokens ihre Position innerhalb des Satzes vermitteln.

Der Prozess der Textgenerierung

Der Prozess der Textgenerierung ist in der Praxis erstaunlich effektiv. So funktioniert es:

- Startpunkt: Du gibst dem Modell einen Textausschnitt.

- Vorhersage: Das Modell berechnet, welche Wörter oder welcher Satz mit der höchsten Wahrscheinlichkeit als Nächstes folgt.

- Sampling: Aus dieser Verteilung wird eine Auswahl getroffen. Dabei kann das Modell deterministisch vorgehen (greedy sampling) oder zufällige Elemente einbringen (z. B. durch Top-k oder Top-p Sampling), um kreativere Ergebnisse zu erzeugen.

- Wiederholung: Der neue Text wird dem ursprünglichen Text hinzugefügt, und der Prozess beginnt von vorne.

Durch diese wiederholten Vorhersagen und das ständige Aktualisieren des Textes entsteht ein längerer, zusammenhängender Text.

Der Fluss der Daten durch einen Transformer

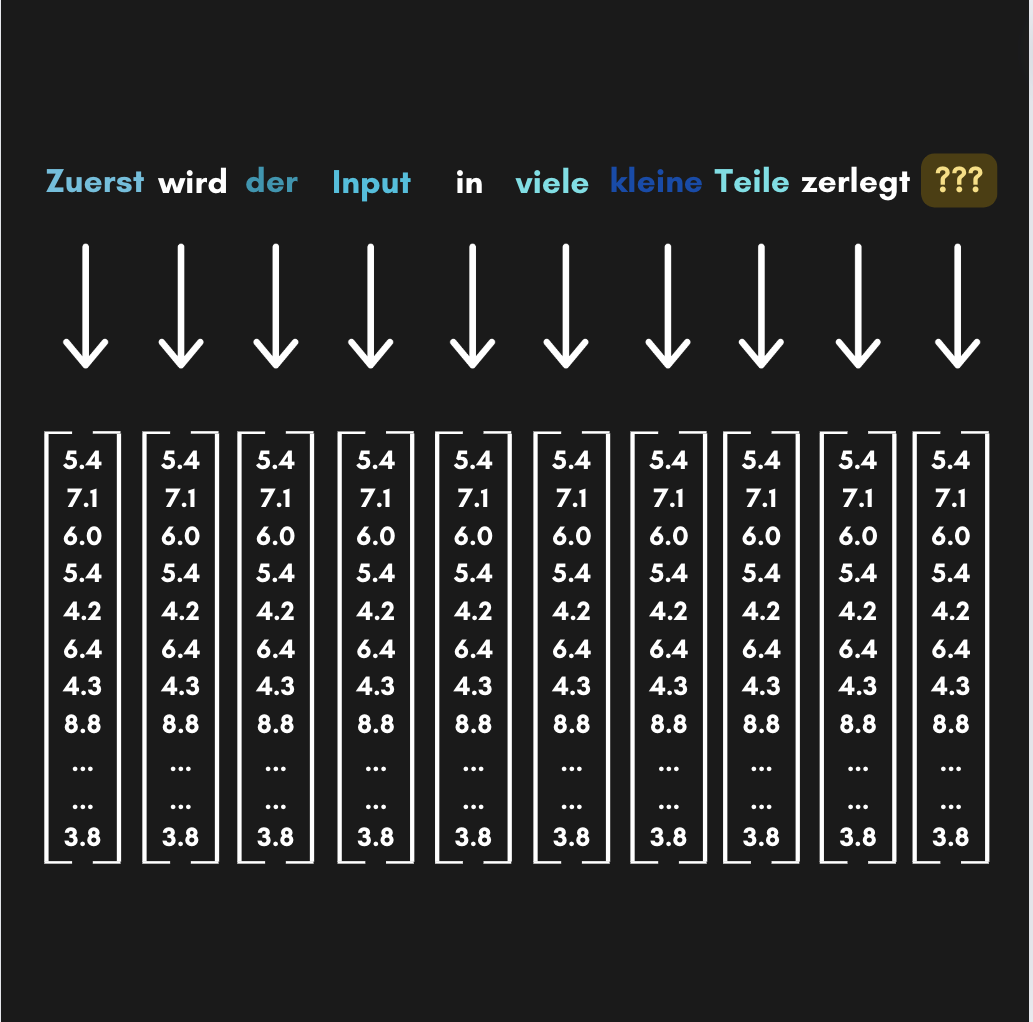

Transformer-Modelle beginnen mit der Zerlegung des Inputs in kleine Teile, die sogenannten Tokens. Im Fall von Texten sind dies Wörter oder Wortteile, bei Bildern oder Tönen können es entsprechende kleinere Abschnitte sein.

- Tokenisierung: Der Input wird in Tokens aufgeteilt.

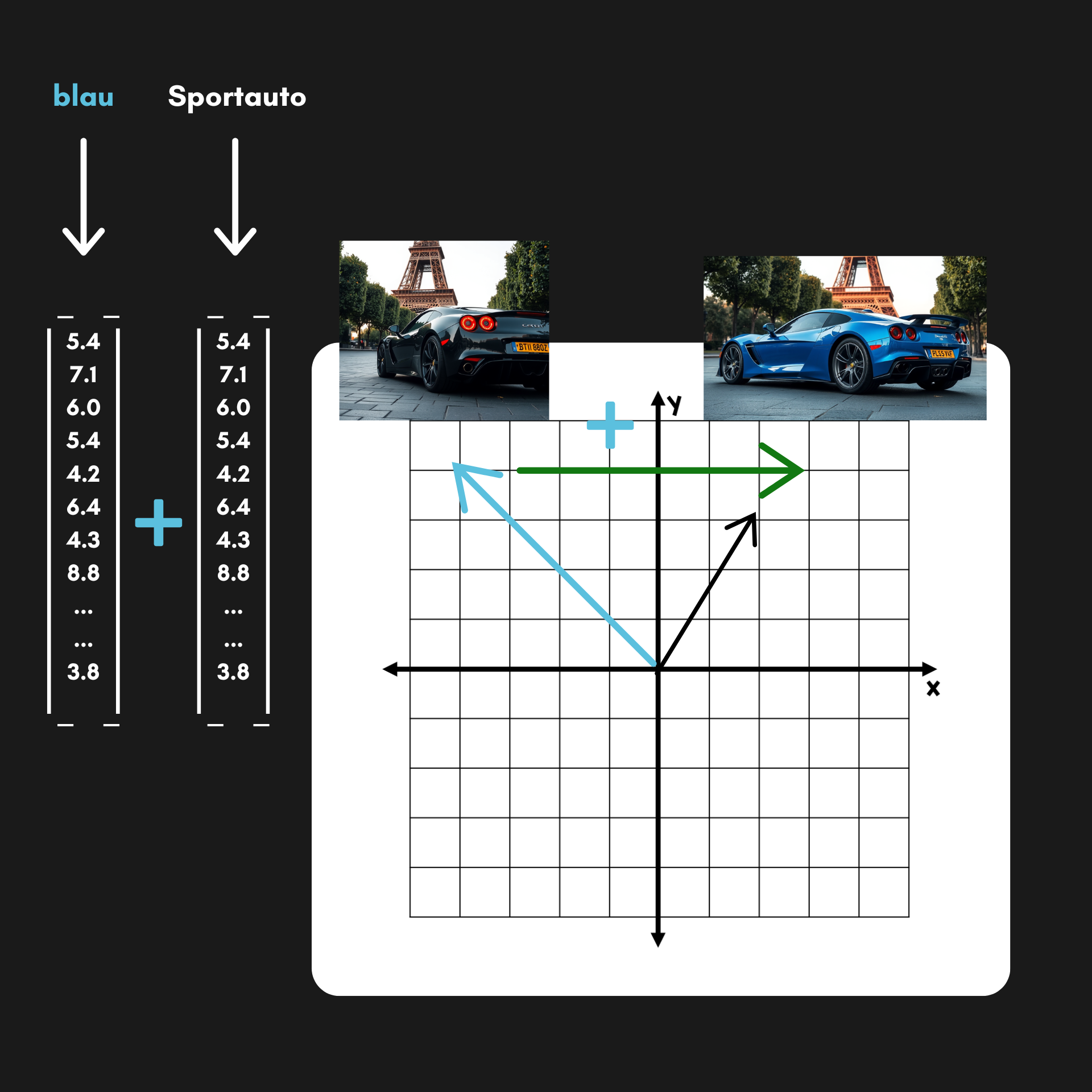

- Input Embeddings: Jeder Token wird mittels der Embedding-Matrix in einen Vektor umgewandelt, einer Liste von Zahlen, die seine Bedeutung kodieren.

- Attention Layer / Block: Die Vektoren werden mittels Selbstaufmerksamkeits-Mechanismen (Attention Blöcke) miteinander in den Kontext gesetzt. Dadurch kann das Modell den Einfluss der Tokens untereinander interpretieren, unabhängig von ihrer Position in der Sequenz.

- Softmax: Am Ende des Prozesses wird die Softmax-Funktion verwendet, um aus den Ergebnissen der Berechnungen Wahrscheinlichkeiten für das nächste Token zu erhalten.

Warum sind Transformer-Modelle so leistungsfähig?

Die Stärke von Transformern liegt in ihrer Fähigkeit, den Kontext von Wörtern und anderen Datenpunkten zu berücksichtigen. Durch die Selbstaufmerksamkeit können sie tiefere Bedeutungen und Zusammenhänge erkennen und nutzen. Dies führt zu beeindruckenden Ergebnissen bei der Textgenerierung, Übersetzung, Bildanalyse und vielen anderen Aufgaben.

Warum ist das spannend?

Stell dir vor, du arbeitest an einem Bericht für die Arbeit und möchtest komplizierte Daten verständlich zusammenfassen. Transformer-Modelle können dir dabei helfen, kreative und präzise Texte zu generieren, die deinem Stil und Zweck entsprechen. Die Möglichkeiten sind endlos: von Chatbots über automatische Übersetzungen bis hin zur Erstellung von Inhalten für Social Media.

Also, das nächste Mal, wenn du mit einem KI-Tool wie ChatGPT interagierst, denk daran: Du nutzt ein Tool, das in Sekundenschnelle komplexe Zusammenhänge erkennt und dir genau das liefert, was du brauchst. Faszinierend, oder?